SEED-V 实验设定

本实验采用的情绪诱导方法是刺激材料诱导,换句话说,通过让受试者观看特定的情绪刺激材料来实现诱导受试者相应情绪状态的目的。

为了研究情绪识别的稳定性并确保刺激的有效性,要求每位受试者参与三次实验,实验之间至少间隔三天。每次实验中,受试者需要观看15段刺激材料,每种情绪类型3段。同时,为确保刺激的有效性并防止受试者产生厌烦情绪,受试者在每次实验中观看的材料完全不同,且每次实验观看材料的总时长控制在约50分钟。在一个试验中,参与者观看一个电影片段,同时使用62通道

ESI NeuroScan系统和

SMI眼动追踪眼镜收集他/她的脑电信号和眼动数据。

所有刺激材料在播放前有15秒的时间介绍材料背景和想要诱导的情绪。刺激材料播放结束后,根据材料类型会有15秒或30秒的自我评估和休息时间。如果刺激材料类型为厌恶或恐惧,休息时间为30秒,而快乐、中性和悲伤的休息时间为15秒。具体流程如下图所示。

在自我评估部分,要求受试者根据刺激材料的诱导效果进行评分。评分范围为0-5分,其中5分代表最佳诱导效果,0分代表最差。如果参与者在观看快乐视频后感到快乐,应该给予4-5分,如果没有任何感觉,则应给予0分。值得一提的是,如果观看中性刺激材料,受试者情绪波动应得0分,而自然状态为5分。

受试者

本实验收集了20名受试者的数据,包括10名男性和10名女性。所有受试者通过社交平台招募,均为上海交通大学学生,具有正常听力和视力,右手为主导手,精神状态稳定。受试者通过社交平台表达参与实验意愿后,将接受艾森克EPQ人格测试。

特征提取

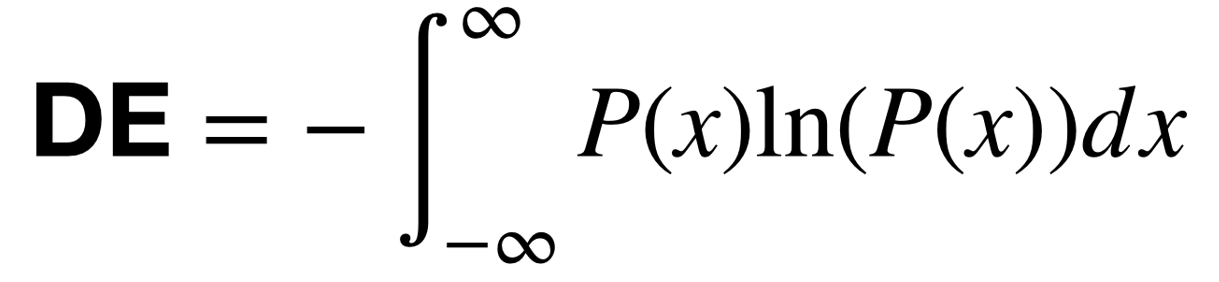

脑电特征

对于脑电信号处理,原始脑电数据首先被降采样至200 Hz采样率。为了过滤噪声并去除伪影,脑电数据随后通过1 Hz到75 Hz之间的带通滤波器进行处理。之后,我们在5个频带内提取每个片段的差分熵(DE)特征:1)δ:1~4 Hz;2)θ:4~8 Hz;3)α:8~14 Hz;4)β:14~31 Hz;和5)γ:31~50 Hz。

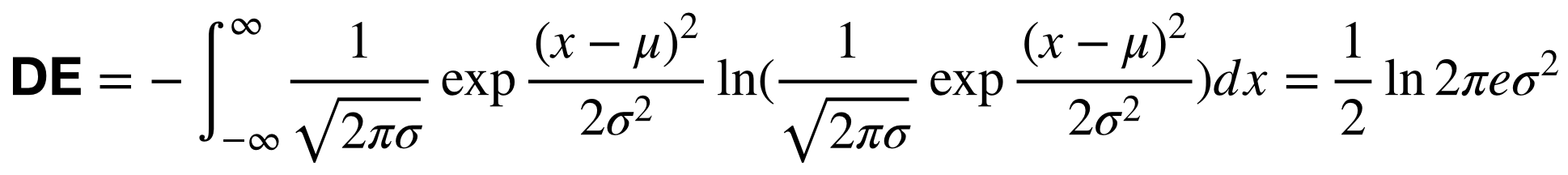

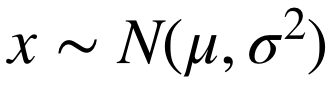

我们假设脑电信号服从高斯分布:

。

因此,DE特征的计算可以简化为:

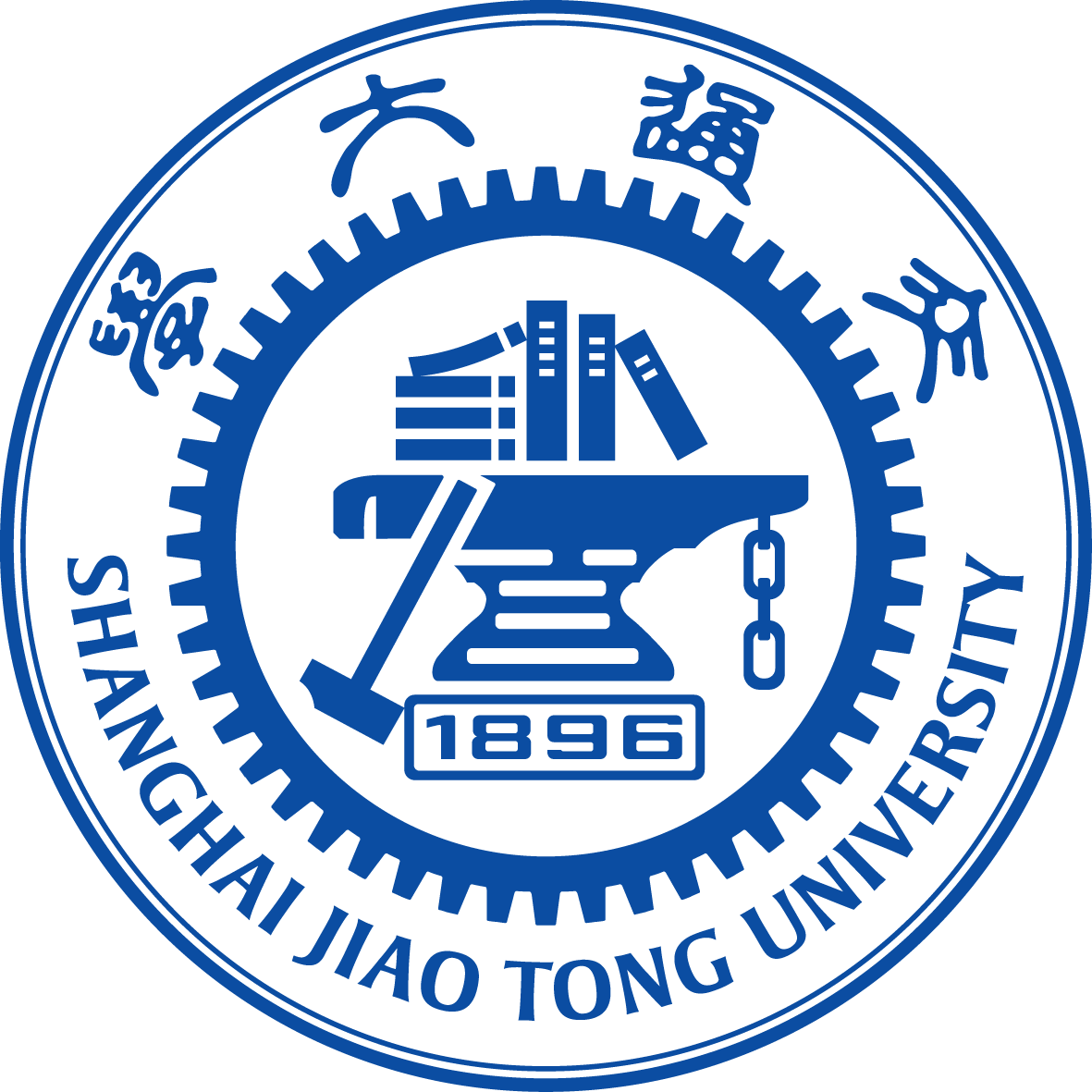

眼动特征

对于使用SMI眼动追踪眼镜收集的眼动信息,我们从文献中使用的各种详细参数中提取了不同特征,如瞳孔直径、注视、眼跳和眨眼。

眼动特征的详细列表如下所示。

数据集概述

-

文件夹EEG_DE_features:

该文件夹包含16名参与者的DE特征和一个提供加载数据示例代码的Jupyter notebook文件。特征数据以"subjectID_sessionID.npz"命名。例如,文件"1_123.npz"表示这是第一个受试者的DE特征,包含了三个会话的DE特征。

-

文件夹EEG_raw:

该文件夹包含使用Neuroscan设备收集的原始脑电数据(.cnt文件)和一个提供加载数据示例代码的Jupyter notebook文件。原始数据以"subjectID_sessionID_date.cnt"格式命名。例如,"1_1_20180804.cnt"表示这是第一个受试者的第一个会话的原始数据。**注意:会话编号是基于观看的刺激材料给出的,而不是基于时间。**

-

文件夹Eye_movement_features:

该文件夹包含提取的眼动特征。

-

文件夹Eye_raw:

该文件夹包含从眼动追踪设备中提取的Excel文件。

-

文件夹src:

该文件夹包含两个子文件夹"DCCA-with-attention-mechanism"和

"MultualInformationComparison",它们是论文"W. Liu, J. -L. Qiu, W. -L. Zheng and B. -L. Lu,

"Comparing Recognition Performance and Robustness of Multimodal Deep Learning

Models for Multimodal Emotion Recognition," in IEEE Transactions on Cognitive

and Developmental Systems, doi: 10.1109/TCDS.2021.3071170."中使用的DCCA模型和计算互信息的代码。

-

文件trial_start_end_timestamp.txt:

该文件包含刺激电影片段的开始和结束时间。

-

文件emotion_label_and_stimuli_order.xlsx:

该文件包含情绪标签和刺激顺序。

-

文件Participants_info.xlsx:

该文件包含受试者的元信息。

-

文件Scores.xlsx:

该文件包含参与者的反馈评分。

下载

下载SEED-V数据集

下载SEED-V数据集

参考文献

如果您觉得该数据集对您的研究有帮助,请在您的出版物中添加以下参考文献。

Wei Liu, Jie-Lin Qiu, Wei-Long Zheng and Bao-Liang Lu, Comparing Recognition Performance and Robustness of Multimodal Deep Learning Models for Multimodal Emotion Recognition,

IEEE Transactions on Cognitive and Developmental Systems, 2021.

[链接]

[BibTex]

。

因此,DE特征的计算可以简化为:

。

因此,DE特征的计算可以简化为: