SEED Dataset

使用脑电信号的多用途数据集合

SEED-FRA 实验设定

|

每个电影片段的持续时间约为1至4分钟。 每个电影片段经过精心编辑,以创造连贯的情绪诱导并最大化情绪意义。

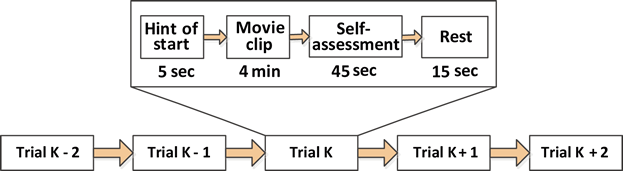

每位受试者参与了三次实验,每次实验包含21个试验。 在一个会话中,每个片段前有5秒的提示,片段后有45秒用于自我评估和15秒的休息时间。呈现顺序的安排方式使得两个针对相同情绪的电影片段不会连续显示。在反馈环节,要求参与者在观看每个片段后立即完成问卷,报告他们对每个电影片段的情绪反应。详细流程如下所示:

|

|

受试者

8名法国受试者(5名男性和3名女性;平均年龄:22.5,标准差:2.78)参与了实验。 为保护个人隐私,我们隐去了他们的姓名,并用1至8的数字表示每位受试者。数据集概述

SEED-FRA的详细内容如下所示:- 'French'文件夹包含四个子文件夹。

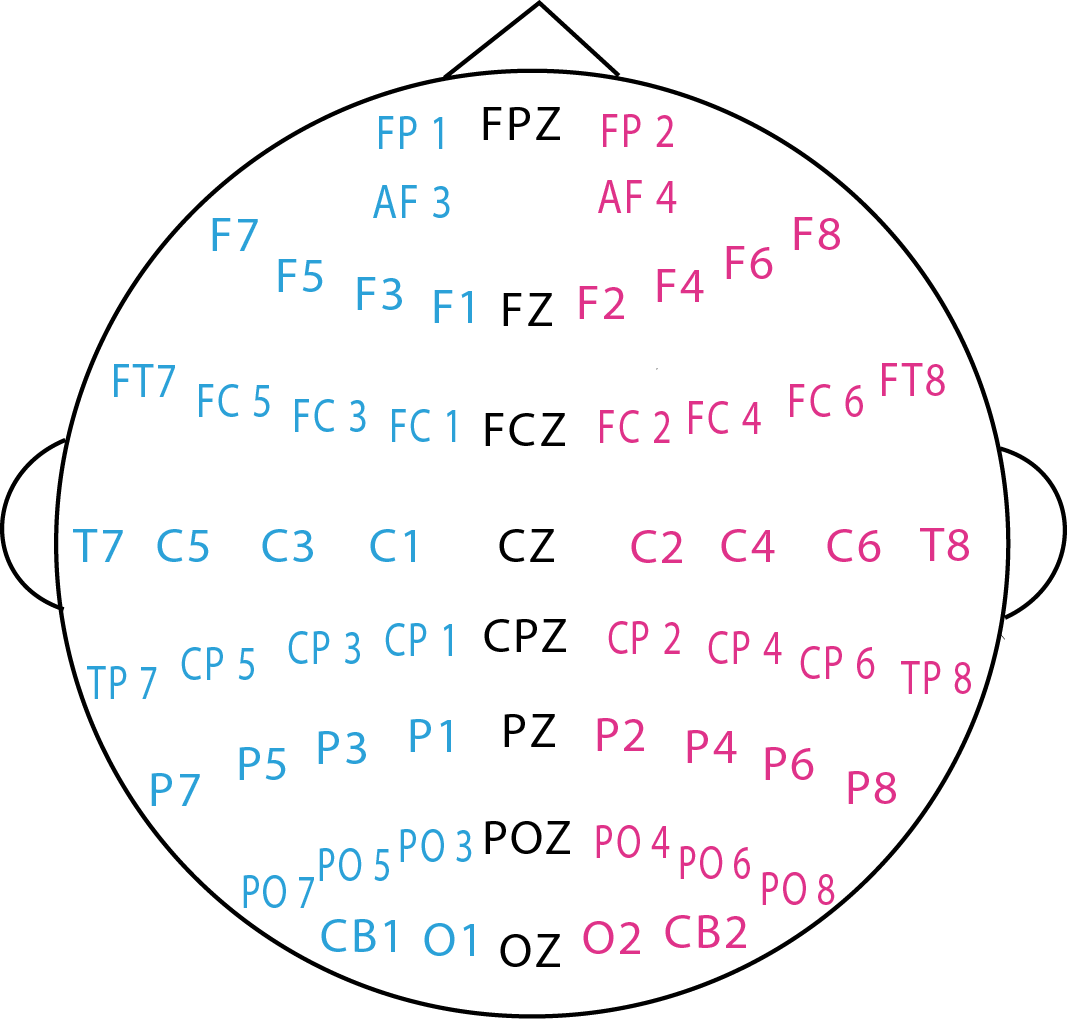

- 01-EEG-raw:包含采样率为1000Hz的.cnt格式原始脑电信号。

- 02-EEG-DE-feature:包含使用1秒和4秒滑动窗口提取的DE特征以及读取数据的源代码。

- 03-Eye-tracking-excel:包含眼动追踪信息的excel文件。

- 04-Eye-tracking-feature:包含pickle格式的眼动追踪特征和读取数据的源代码。

- 'code'文件夹包含本论文中使用的模型源代码。

- SVM、KNN和逻辑回归源代码。

- DNN源代码。

- 传统融合方法。

- 双模态深度自编码器。

- 带注意力机制的深度典型相关分析。

- 源代码也可在GitHub上获取。

- 'information.xlsx':包含实验和受试者信息。

- 对于电影片段,积极、消极和中性情绪分别标记为1、-1和0。

- 为构建分类器,我们对积极、消极和中性情绪分别使用2、0和1(即电影片段标签加1)。此外,我们没有在眼动追踪特征中保存标签,因为眼动追踪标签与脑电DE特征的标签相同。

下载

参考文献

如果您觉得该数据集对您的研究有帮助,请在您的出版物中添加参考文献[1]。

1. Wei Liu, Wei-Long Zheng, Ziyi Li, Si-Yuan Wu, Lu Gan and Bao-Liang Lu, Identifying similarities and differences in emotion recognition with EEG and eye movements among Chinese, German, and French People, Journal of Neural Engineering 19.2 (2022): 026012. [link] [BibTex]

2. Schaefer A, Nils F, Sanchez X and Philippot P, Assessing the effectiveness of a large database of emotion-eliciting films: a new tool for emotion researchers, Cognition and Emotion 24.7(2010):1153-1172. [链接] [BibTex]