SEED-VII 实验设定

情绪诱导基于视频片段。每种情绪(除中性外)选择了12个片段。中性情绪包含8个片段,总共80个视频片段。每个视频片段持续2至5分钟,所有片段的总时长约为14,097.86秒。

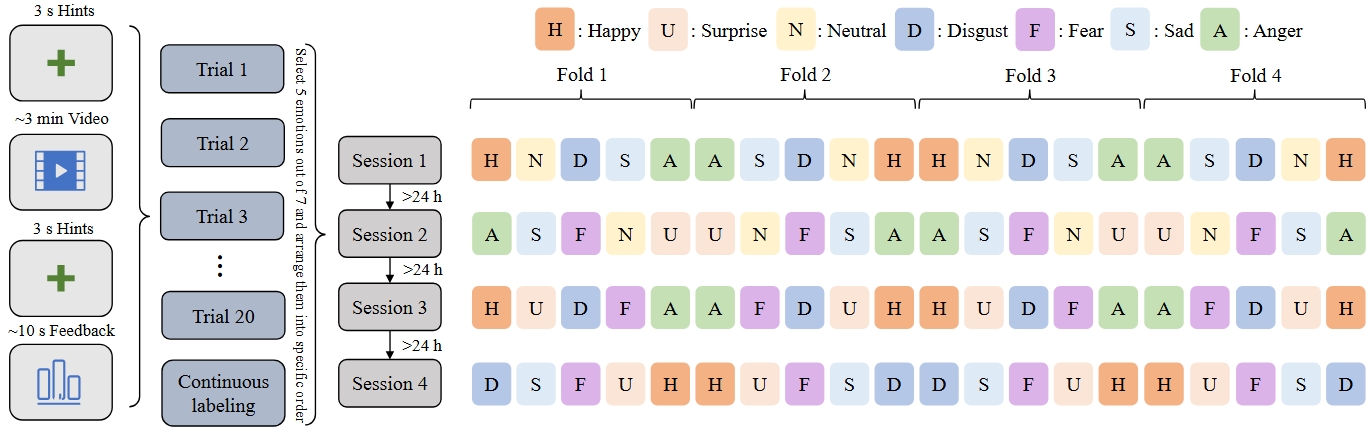

所有受试者经历了四个实验会话。实验流程如下图所示。每个会话包含20个试验;每个试验由两部分组成,第一部分是观看视频,第二部分是自我评估。每个会话只诱导七种情绪中的五种,这减少了受试者切换到太多情绪状态的影响。在每个视频片段开始前和结束后,都提供了3秒的倒计时,以提醒参与者视频即将开始或结束。下图中呈现的视频片段序列经过精心安排,以避免情绪价值突然转变,因为人类情绪通常是逐渐转变的。

来自四个会话的总共80个视频片段被分为四组。每组包含每个会话的五个片段,所有情绪视频数量相等。在每个会话结束时,指导参与者回顾所有20个视频片段,回忆他们在会话期间经历的情绪反应,并通过鼠标滚轮为整个会话分配连续标签。受试者可以自由选择实时或加速时间回顾。

在自我评估部分,要求受试者根据刺激材料的诱导效果进行评分。评分范围为0-1,其中1代表最佳诱导效果,0代表最差。如果参与者在观看欢乐视频后感到欢乐,应得接近1分,如果没有任何感觉,应得0分。值得一提的是,如果观看中性刺激材料,受试者情绪波动应得0分,自然状态为1分。

受试者

二十名受试者(10名男性和10名女性)年龄在19至26岁之间(平均:22.5;标准差:1.80)参与了实验并记录了可用数据。所有参与者都是右撇子,自我报告在上海交通大学有正常或矫正后正常的视力和听力。参与者通过艾森克人格问卷(EPQ)选择,这是艾森克开发的广泛使用的问卷,用于评估个人的性格特质。

特征提取

脑电特征

为减轻噪声影响,我们首先目视检查脑电信号,并使用MNE-Python工具箱对任何不良通道进行插值。然后,我们应用截止频率为0.1 Hz和70 Hz的带通滤波器来去除低频噪声。此外,应用截止频率为50 Hz的陷波滤波器以防止电源线干扰。为减少我们方法的计算复杂性,我们将原始脑电信号从原始采样率1000 Hz降采样至200 Hz。

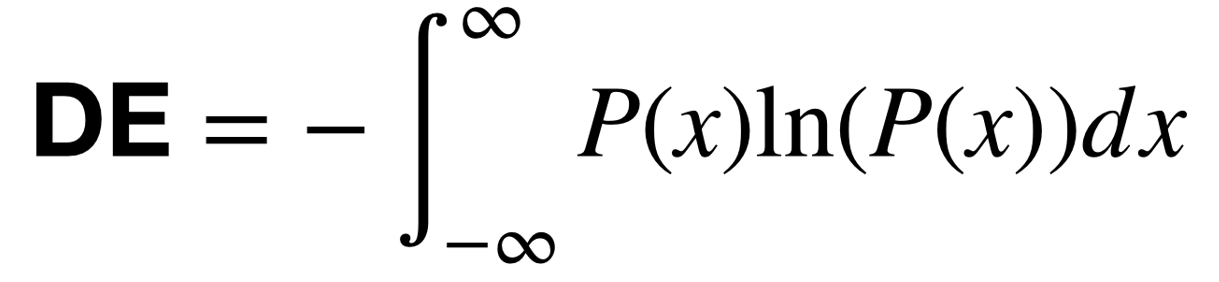

之后,我们在5个频带内提取每个片段的差分熵(DE)特征:1)δ:1~4 Hz;

2)θ:4~8 Hz;3)α:8~14 Hz;4)β:14~31 Hz;以及

5)γ:31~50 Hz。

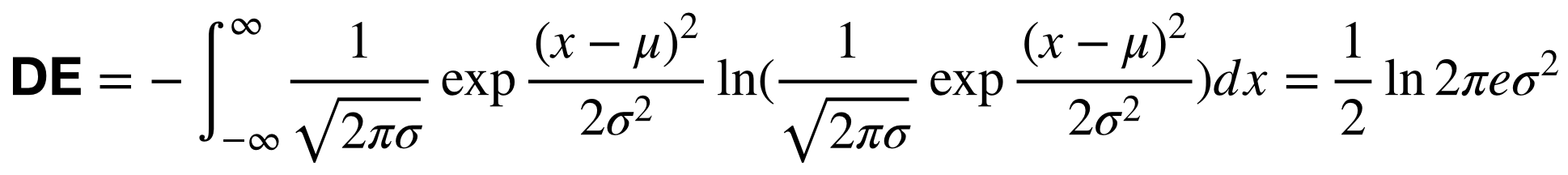

我们假设脑电信号服从高斯分布:

。

然后,DE特征的计算可以简化为:

眼动特征

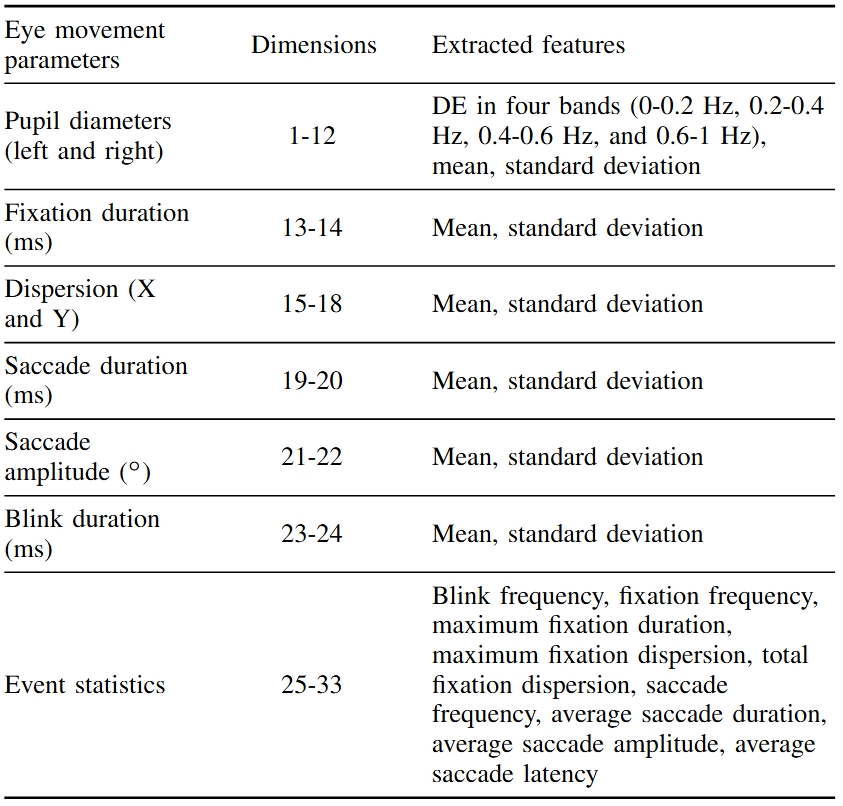

对于使用Tobii Pro Fusion眼动追踪器收集的眼动信息,我们从文献中使用的各种详细参数中提取了不同特征,如瞳孔直径、注视、眼跳和眨眼。

眼动特征的详细列表如下所示。

数据集概述

-

文件夹EEG_features:

该文件夹包含20名参与者的DE特征。特征数据以"subjectID.mat"命名。例如,文件"1.mat"表示这是第一个受试者的DE特征。

每个.mat文件中的键以"de_LDS_videoID"命名。例如,键"de_LDS_1"表示第一个视频试验中经LDS算法平滑的DE特征。键"de_80"表示第80个视频试验中未经平滑的DE特征。

-

文件夹EEG_raw:

该文件夹包含使用Neuroscan设备收集的原始脑电数据(.cnt文件)。原始数据以"subjectID_date_sessionID.cnt"格式命名。例如,"1_20221001_1.cnt"表示这是第一个受试者的第一个会话的原始数据。**注意:会话编号是基于观看的刺激材料给出的,而不是基于时间。**

-

文件夹EYE_features:

该文件夹包含提取的眼动特征。

-

文件夹EYE_raw:

该文件夹包含从眼动追踪设备中提取的tsv文件。

-

文件夹src:

该文件夹包含两个文件。load_cnt_file_with_mne.py是一个加载cnt文件、预处理和根据触发器裁剪脑电信号的示例代码。channel_62_pos.locs是62通道脑电头皮的蒙太奇文件。

-

文件夹save_info:

该文件包含两种文件。第一种文件以"subjectID_date_sessionID_trigger_info.csv"格式命名,包括刺激电影片段的开始和结束时间。具体来说,触发器1表示试验的开始时间,触发器2表示试验的结束时间。其他种类的文件以"subjectID_date_sessionID_save_info.csv"格式命名,包括受试者对每个电影片段的反馈。分数为0到1,表示每个视频成功诱导目标情绪的程度。

-

文件emotion_label_and_stimuli_order.xlsx:

该文件包含情绪标签和刺激顺序。

-

文件subject info.xlsx:

该文件包含受试者的元信息。

-

文件Channel Order.xlsx:

该文件包含DE特征的通道顺序。

下载

下载SEED-VII数据集

下载SEED-VII数据集

参考文献

如果您觉得该数据集对您的研究有帮助,请在您的出版物中添加以下参考文献。

Wei-Bang Jiang, Xuan-Hao Liu, Wei-Long Zheng and Bao-Liang Lu, SEED-VII: A Multimodal Dataset of Six Basic Emotions with Continuous Labels for Emotion Recognition,

IEEE Transactions on Affective Computing, vol. 16, no. 2, pp. 969-985, April-June 2025, doi: 10.1109/TAFFC.2024.3485057.

[链接]

[BibTex]

。

然后,DE特征的计算可以简化为:

。

然后,DE特征的计算可以简化为: